大模型也需要自我反思,上海AI Lab合成“错题本”让大模型数学成绩提升13.3%

大模型也需要自我反思,上海AI Lab合成“错题本”让大模型数学成绩提升13.3%大模型学习不仅要正确知识,还需要一个“错题本”?

大模型学习不仅要正确知识,还需要一个“错题本”?

据自媒体“申妈的朋友圈”消息,知情人士透露,字节人工智能实验室 (AI Lab) 负责人李航已经正式卸任,他在内部系统的身份变为劳务/顾问。

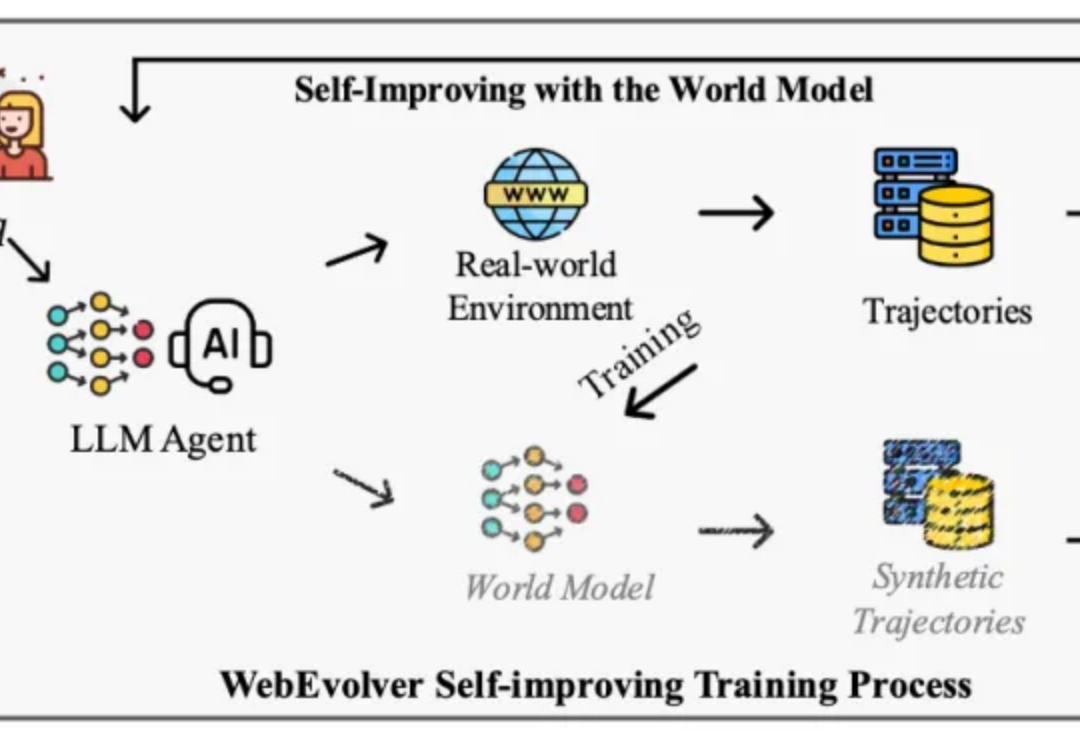

让网页智能体自演进突破性能天花板!

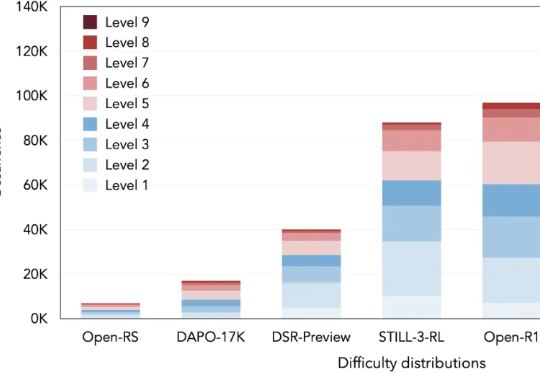

本文将介绍 DeepMath-103K 数据集。该工作由腾讯 AI Lab 与上海交通大学团队共同完成。

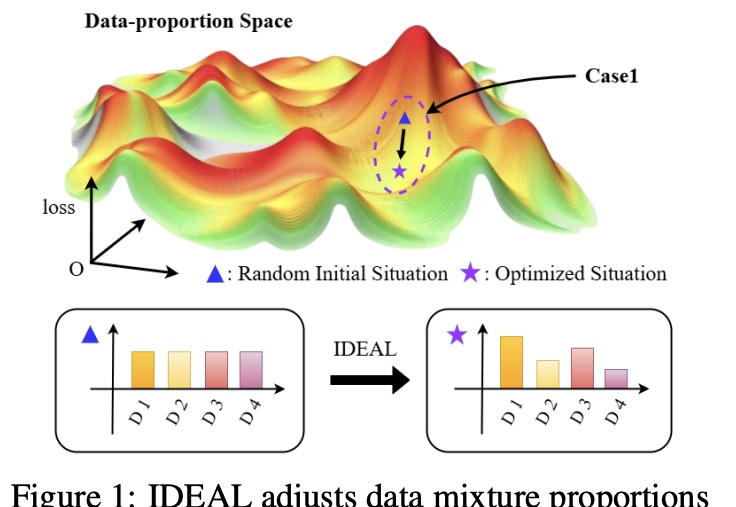

大幅缓解LLM偏科,只需调整SFT训练集的组成。

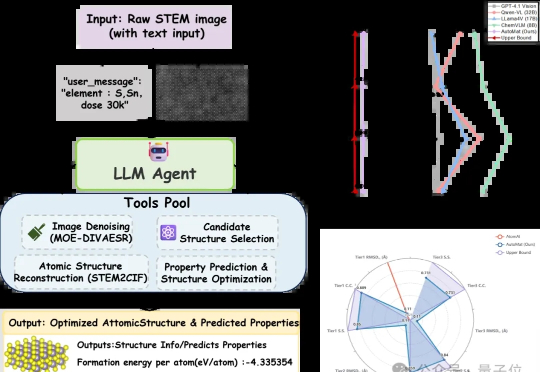

AI Agent又解锁了一个领域!清华大学牵头,与西北工业大学以及上海AI lab等机构推出了电镜领域的AI agent——AutoMat。

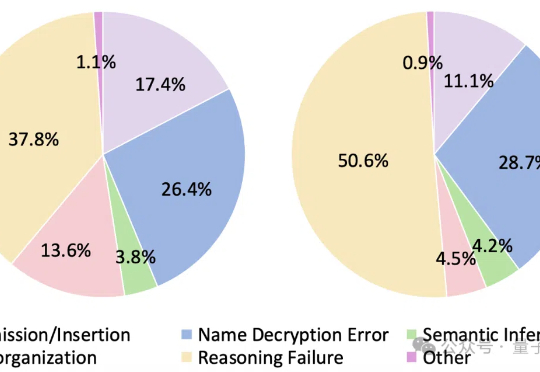

大语言模型遇上加密数据,即使是最新Qwen3也直冒冷汗!

2002年,在拿下中国高校第一个ACM(计算机领域最顶尖的程序设计大赛)金牌后,上海交大设立了“ACM班”,这个用最高竞赛命名的班级后来人尽皆知,成为中国AI人才的重要阵地。也在那年,李磊成为ACM班第一届的学生。在ACM班他第一次意识到,“原来计算机能帮助解决人类的这么多问题。”

围棋因其独特的复杂性和对人类智能的深刻体现,可作为衡量AI专业能力最具代表性的任务之一。

OpenAI 研究员姚顺雨近期发布文章,指出:AI 下半场将聚焦问题定义与评估体系重构。在 AI 发展新阶段,行业需要通过设计更有效的模型评测体系,弥补 AI 能力与真实需求的差距。